centos7.2(linux)+spark2.1.0安装教程图解

centos7.2(linux)+spark2.1.0安装,介绍下spark在Linux上的安装.。

操作系统是cent os, cent os其实是纯净版的Linux.spark版本选2.x以上.2.1.0是去年中旬刚出来的.

(1)spark 1.x与2.x区别

1.x是可以向下兼容的,2.x与1.x不完全兼容,2.x比1.x改进了许多bug. 1.x和2.x都支持更高版本的Hadoop,因此不用担心,按喜好选择吧.

(2)下载spark

下载地址,百度.

(3)安装

解压,放到/usr路径下,本人的是:

/usr/spark

配置spark安装路径,打开.bash_profile.这个文件里面要预先配置java path.

#set spark path

export SPARK_HOME=/usr/spark

export PATH=$SPARK_HOME/bin:$PATH

source ~/.bash_profile

回到spark目录,

./bin/spark-shell

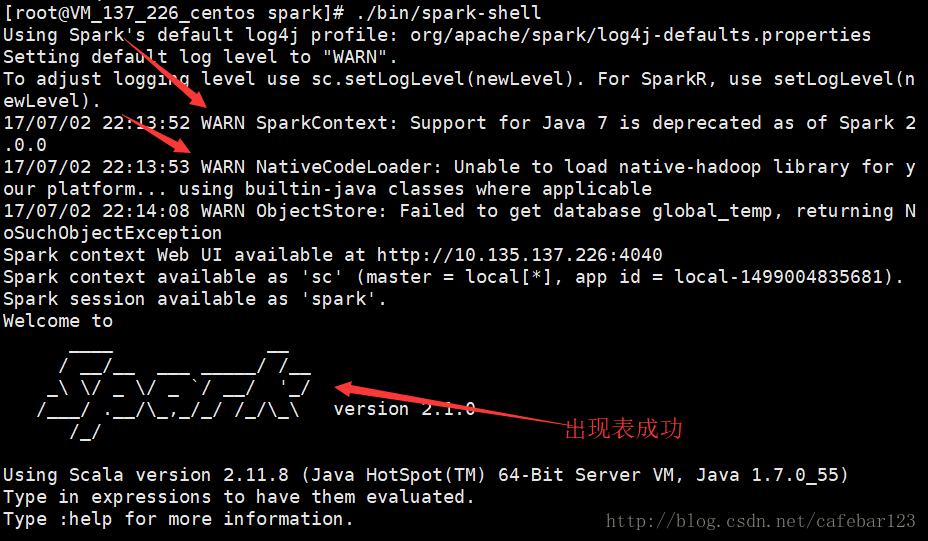

spark-shell 是一个简单的输入命令行的操作spark的方式,如图:

(图中上面的2个警告,本人还在研究中,不过不影响spark的运行)

(4)配置spark内存

在spark路径下面,先关掉spark-shell:

:help

:quit

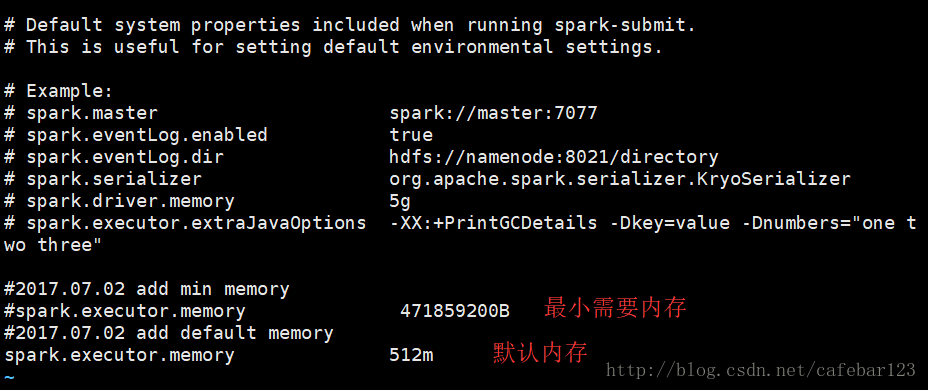

然后配置内存(可省略,默认512M):

cp ./conf/spark-defaults.conf.template ./conf/spark-defaults.conf

vi ./conf/spark-defaults.conf

# Example:

# spark.master spark://master:7077

# spark.eventLog.enabled true

# spark.eventLog.dir hdfs://namenode:8021/directory

# spark.serializer org.apache.spark.serializer.KryoSerializer

# spark.driver.memory 5g

# spark.executor.extraJavaOptions -XX:+PrintGCDetails -Dkey=value -Dnumbers="one two three"

# add min memory

#spark.executor.memory 471859200B

#add default memory

spark.executor.memory 512m

(5)简单测试

./bin/spark-shell

val textFile = sc.textFile("/testdata/words.txt")

textFile.count()

(6)/etc/profile 与~/.bash_profile的区别,参考:

http://blog.csdn.NET/caiwenfeng_for_23/article/details/44242961

(7)spark启动与Hadoop的关系

听说,spark是建立在hadoop基础上的,spark的许多jar文件都是沿用Hadoop的.但是,就启动spark而言,同一台机器并不需要先安装Hadoop.本人试过。

热门标签:dede模板 / destoon模板 / dedecms模版 / 织梦模板